Sakana AI, startup-ul japonez care în martie 2025 a surprins lumea științifică cu o lucrare creată de inteligența artificială IA care a trecut procesul de evaluare inter pares (în engleză peer review) revine în centru atenției cu o nouă paradigmă de dezvoltare a agenților AI.

Urmărește cele mai noi producții video TechRider.ro

– articolul continuă mai jos –

Un obiectiv al cercetării în domeniul inteligenței artificiale a fost crearea unei inteligențe artificiale care să poată învăța la nesfârșit. O cale către acest obiectiv este o IA care se îmbunătățește singură prin rescrierea propriului cod, inclusiv a codului responsabil de învățare.

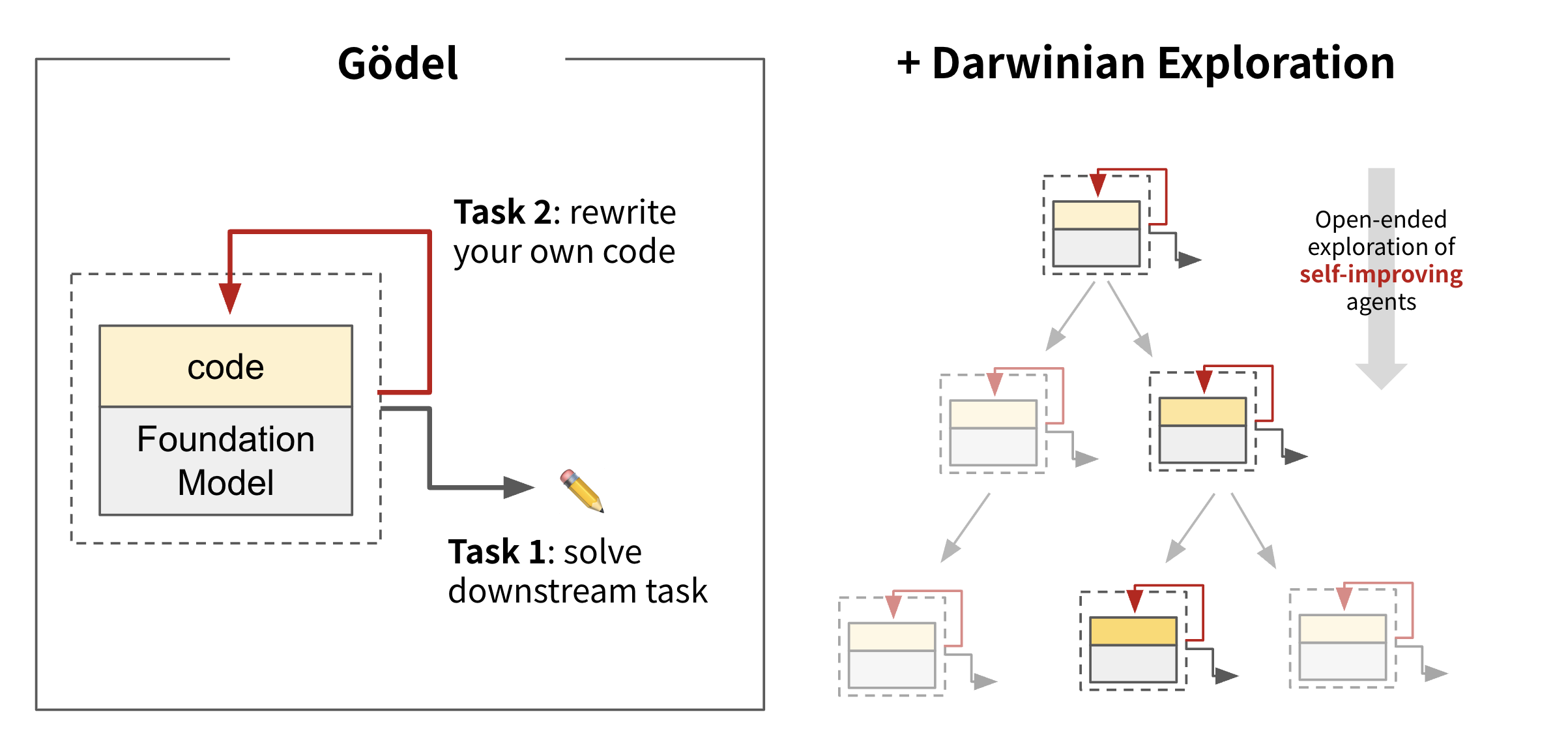

Startup-ul japonez împreună cu cercetători de la Universitatea British Columbia au dezvoltat Darwin-Gödel Machine (DGM), un sistem de inteligență artificială IA conceput pentru a evolua de unul singur. În locul optimizării pentru obiective fixe, DGM se inspiră din evoluția biologică și descoperirile științifice, utilizând căutarea deschisă și auto-modificarea continuă pentru a genera soluții noi. Procesul a fost descris în lucrarea publicată pe arxiv.

Sursele de inspirație: Evoluția, Gödel și caracterul deschis, open-ended

Numele „Darwin Gödel Machine” în sine face aluzie la conceptele care stau la baza proiectării sale.

Învățând de la Darwin: puterea evoluției

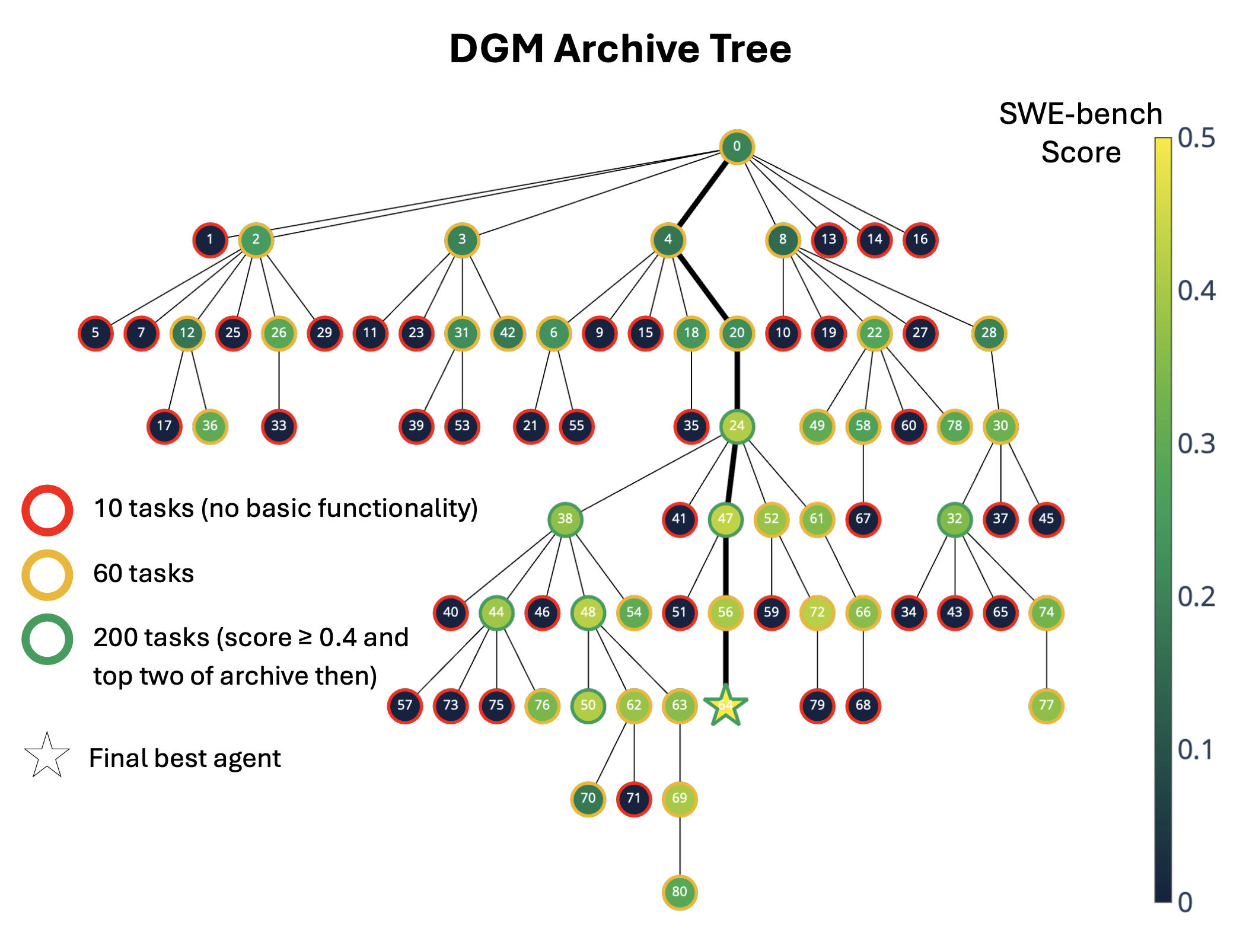

Aspectul „Darwin” se referă la principiile evoluției biologice. DGM păstrează o arhivă, sau o „descendență”, a diferitelor versiuni ale agenților de codificare. Noi agenți AI (descendenți) apar atunci când sistemul îi modifică pe cei existenți (părinți). Inspirându-se din selecția naturală, sistemul păstrează în arhivă variantele de succes sau interesante, permițându-le să contribuie la creșterea unui arbore diversificat de agenți de înaltă calitate. DGM explorează deschis multe căi diferite prin vastul spațiu de căutare a îmbunătățirilor posibile, în loc să se blocheze pe o singură soluție, potențial suboptimă.

Inspirat și de Gödel mașina teoretică a lui Jürgen Schmidhuber

Mașina teoretică Gödel a lui Jürgen Schmidhuber a inspirat partea „Gödel” din numele agentului AI; aceasta descrie o IA care se auto-perfecționează și care poate îmbunătăți în mod demonstrabil propriul cod atunci când descoperă o strategie mai bună de rezolvare a problemelor. Cu toate acestea, demonstrarea matematică a impactului majorității automodificărilor în sistemele complexe de IA este practic imposibilă. Darwin Gödel Machine adoptă o abordare mai pragmatică. În loc să necesite dovezi verificabile matematic, validează empiric fiecare modificare. Dacă o modificare a propriului cod duce la o performanță mai bună în testele de codare, acea modificare este considerată benefică și este incorporată. Acest lucru reflectă metoda științifică: propune o modificare, testeaz-o și adopt-o dacă funcționează.

Explorarea deschisă

O caracteristică cheie a DGM este angajamentul său față de caracterul deschis. Acest lucru înseamnă că sistemul este proiectat să genereze continuu soluții sau comportamente noi și din ce în ce mai complexe. Prin menținerea unei arhive a tuturor agenților de codificare generați, chiar și a celor care nu sunt imediat cei mai performanți, DGM poate revizui „trepte” mai vechi care ar putea debloca descoperiri viitoare. Acest lucru împiedică sistemul să meargă prematur către un optim local și încurajează descoperirea de capacități cu adevărat noi.

Un optim local, în situația aceasta, este o soluție care este cea mai bună într-o anumită zonă a spațiului de căutare, dar poate să nu fie cea mai bună soluție în ansamblu. Este important să se facă distincția între optimul local și optimul global în optimizarea procesului, deoarece optimul local poate să nu fie cel mai potrivit și poate duce la rezultate finale suboptimale.

Cum funcționează Darwin Gödel Machine

La baza DGM se află un proces iterativ. Un agent AI își rescrie propriul cod Python pentru a produce noi versiuni ale sale, fiecare cu instrumente, fluxuri de lucru sau strategii diferite.

Acest ciclul iterativ poate fi înțeles în linii mari în următoarea structură.

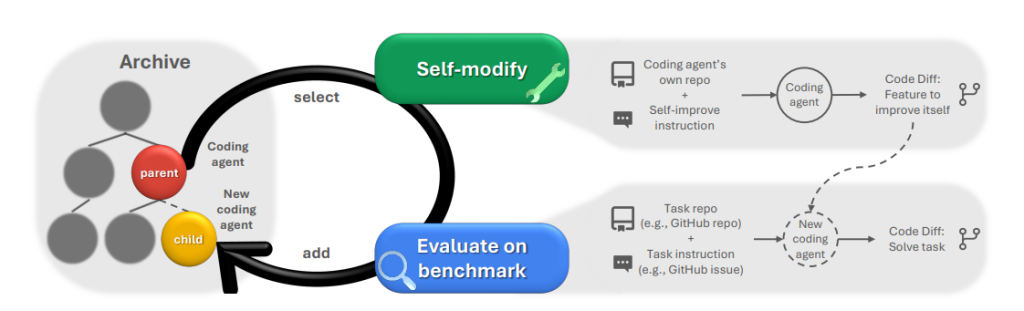

Arhiva agenților: DGM începe cu un agent de codificare inițial și menține o arhivă în continuă creștere a tuturor variantelor de agenți generați. Acești agenți sunt alimentați de modele AI de bază „înghețate” (modele AI mari, pre-antrenate) și au capacitatea de a citi, scrie și executa cod folosind instrumente. Modele AI de bază (FM), sau modele de frontieră cum mai sunt cunoscute, se consideră a fi „înghețate” datorită procesului lor de antrenare. Dezvoltatorii lor acumulează toate datele disponibile până la o dată fixă, numita cut-off date, și apoi, pe baza acestor date, sunt antrenate aceste modele LLM de frontieră. Astfel modelele AI (FM) se consideră că sunt înghețate în timp, deoarece după data cut-off nu mai pot acumula date noi și nu mai pot fi îmbunătățite.

Selecția: Un agent (sau agenți) este selectat din arhivă pentru a fi „reprodus”. Acest proces de selecție favorizează adesea agenții cu performanțe mai ridicate, dar include și mecanisme care asigură diversitatea și explorarea continuă (noutatea).

Auto-modificare: Agentul selectat încearcă apoi să se îmbunătățească. Aceasta este o sarcină de codificare în care agentul își modifică propria bază de cod. De exemplu, ar putea îmbunătăți instrumentele de editare a codului, îmbunătăți gestionarea ferestrelor cu context lung sau chiar rafina mecanismele de revizuire inter pares, sau peer review.

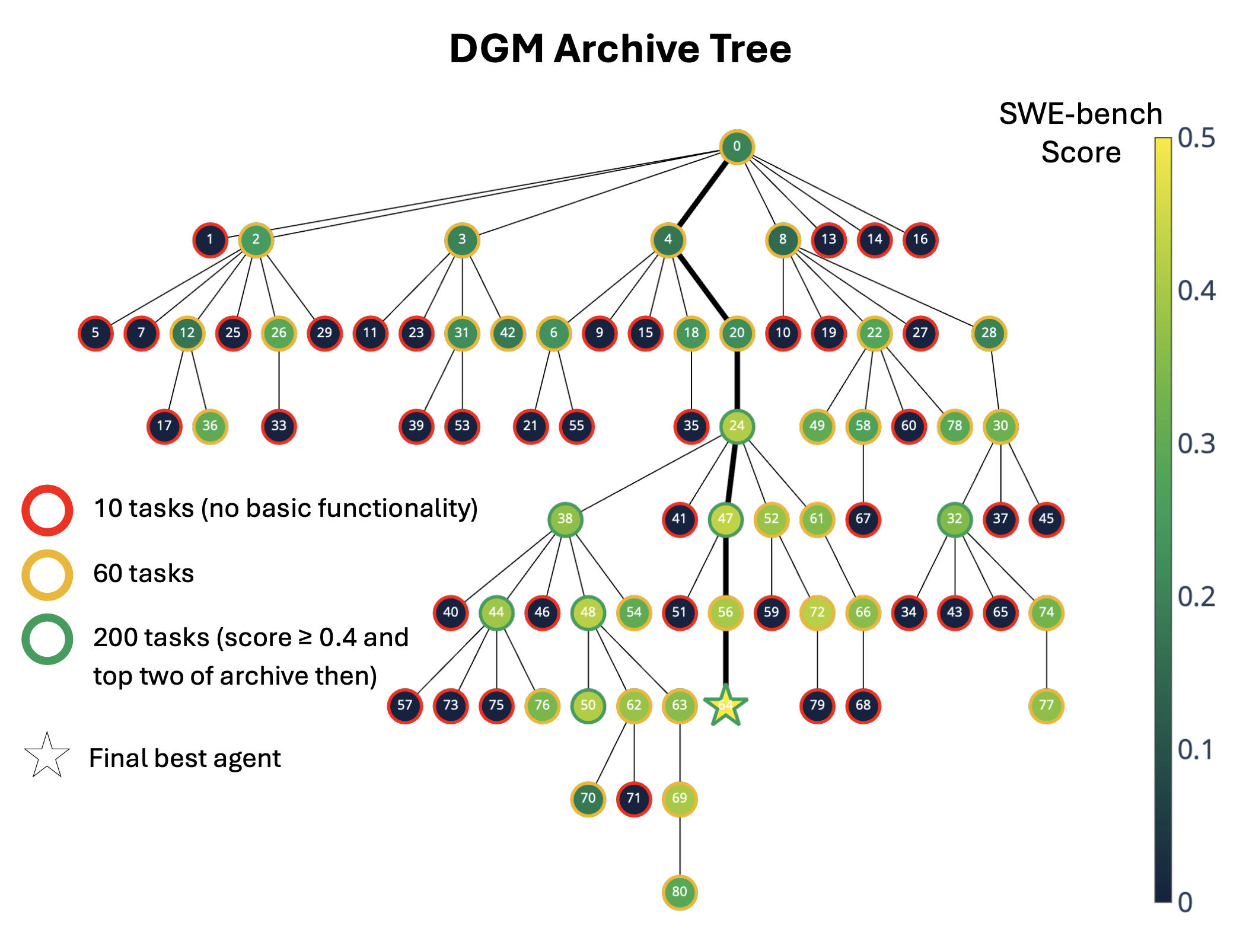

Evaluarea pe baza unor repere: Agentul nou modificat este apoi testat pe repere standard de codificare (cum ar fi SWE-bench sau Polyglot). Aceste repere evaluează capacitatea agentului de a rezolva probleme de codificare din lumea reală. Acest proces de selecție prioritizează agenții pe baza unei combinații între performanța lor (acordând o pondere ridicată scorurilor mai mari) și un bonus de noutate (corelat invers cu numărul de descendenți pe care i-au produs deja, încurajând astfel explorarea căilor mai puțin frecventate).

Actualizarea arhivei: Dacă noul agent compilează cu succes și demonstrează capacități de codificare (și, potențial, o îmbunătățire), acesta este adăugat la arhivă. Prin menținerea unei arhive a tuturor agenților generați, documentând astfel progresul liniei genealogice a îmbunătățirilor calitative cheie, DGM poate explora simultan mai multe traiectorii evolutive. Acest lucru îi permite să descopere „trepte”, caracteristici sau soluții care pot fi temporar suboptimale, dar care pot deschide calea către descoperiri viitoare. Este un mecanism de evitare a optimului local care poate bloca sistemele care se bazează invariabil pe cea mai bună sau cea mai recentă versiune. Ciclul se repetă apoi.

Este esențial faptul că, deși auto-perfecționarea este în sine o sarcină de codare, îmbunătățirile în rezolvarea sarcinilor de codare din benchmark-uri reflectă direct o capacitate sporită a agentului de a se modifica și îmbunătăți. Acest lucru creează o buclă puternică de self-reinforcing. Această abordare, cunoscută sub numele de „căutare deschisă”, este asemănătoare unui arbore genealogic evolutiv.

Cea mai semnificativă evoluție a fost recursivă, sistemul și-a îmbunătățit propriile procese de perfecționare. Nu a devenit doar mai bun la rezolvarea problemelor de codare, ci a devenit mai bun la a deveni mai bun la rezolvarea problemelor de codare.

Rezultate din benchmark-uri la testarea DGM

Darwin Gödel Machine nu este doar un concept teoretic; a demonstrat practic îmbunătățiri ale performanței:

În SWE-bench, un benchmark care implică rezolvarea problemelor GitHub din lumea reală, DGM și-a îmbunătățit automat performanța de la o rată de succes inițială de 20,0% la un impresionant 50,0%.

În Polyglot, un benchmark care include sarcini de codificare în mai multe limbaje de programare, DGM și-a crescut rata de succes de la 14,2% la 30,7%.

Chiar și cu aceste îmbunătățiri, scorul maxim al DGM de 50% pe SWE-bench rămâne în continuare puțin în urma celui mai bun agent open-source, OpenHands + CodeAct v2.1, care a atins 51%. Unele sisteme proprietare au avut performanțe și mai bune. Deși DGM arată rezultate promițătoare, performanța sa pe SWE-bench este încă inferioară unor sisteme cu sursă închisă, foarte optimizate.

Aceste rezultate arată totuși că DGM poate descoperi automat proiecte mai bune pentru agenții de codare. DGM depășește semnificativ valori de referință care nu au capacități de auto-perfecționare sau de explorare deschisă. De fapt, performanța sa a devenit comparabilă sau chiar a depășit soluții open-source care au necesitat eforturi umane considerabile pentru a fi dezvoltate.

Transferabilitatea rezultatelor

Sakana AI a folosit mai multe modele AI fundaționale cum ar fi Claude 3.5 Sonnet, o3-mini și Claude 3.7 Sonnet pentru a alimenta agenții AI DGM. Experimentul a arătat că DGM descoperă îmbunătățiri generale ale proiectării agentului, mai degrabă decât doar trucuri specifice modelului LLM. De exemplu, un agent optimizat cu Claude 3.5 Sonnet a demonstrat, de asemenea, performanțe îmbunătățite atunci când a fost alimentat cu o3-mini sau Claude 3.7 Sonnet.

Această transferabilitate a fost evidentă și în limbajele de programare. O variantă DGM al cărei proces de auto-perfecționare a fost ghidat exclusiv de performanța sa în sarcinile Python din cadrul benchmark-ului Polyglot a demonstrat ulterior creșteri semnificative ale performanței în sarcini din limbaje de programare complet diferite (cum ar fi Rust, C++ și Go) din același benchmark.

DGM diferit de AlphaEvolve

Utilizarea FM-urilor înghețate permite sistemului să se concentreze pe inovarea designului și a fluxurilor de lucru ale agenților de codificare, mai degrabă decât să întreprindă sarcina intensivă din punct de vedere computațional de a reantrena FM-urile în sine. Aceasta este o alegere practică pentru demonstrarea principiilor arhitecturii agenților auto-modificabili. Sisteme precum AlphaEvolve, deși utilizează și algoritmi evolutivi și LLM, se concentrează mai mult pe generarea de soluții la probleme externe definite de utilizatori (de exemplu, descoperiri științifice, optimizarea algoritmilor) prin evoluția codului în blocuri specificate, mai degrabă decât pe revizuirea directă de către agent a propriului cod operațional fundamental pentru rezolvarea problemelor generale.

AlphaEvolve deleagă un model LLM pentru găsirea de soluții specifice de sarcini, în timp ce evoluția DGM este orientată spre a face agentul însuși un mai bun rezolvator de probleme prin auto-modificare.

DGM oferă o cale tangibilă către automatizarea aspectelor dezvoltării IA în sine, sugerând un viitor în care sistemele de IA își pot îmbunătăți recursiv propriile proiecte și accelera ritmul inovării. Este un pas empiric către realizarea conceptului de IA auto-perfecționabilă, prin modificarea iterativă și validată a codului. Abordarea DGM se aliniază viziunii algoritmilor generatori de IA, în care sistemele de IA însele conduc la descoperirea unei IA mai capabile.

Schimbarea de paradigmă: de la cadre fixe la cadre fluide

Acest lucru sugerează o posibilă schimbare în modul în care abordăm dezvoltarea IA. În loc de proiectarea arhitecturilor neuronale mai bune, dezvoltarea AI se poate concentra pe crearea de sisteme care își pot evolua propriile arhitecturi. În loc de optimizarea algoritmilor de antrenare, se poate permite sistemelor să își optimizeze propriile procese de antrenare. În locul conceperii unor instrumente mai sofisticate, am putea permite sistemelor să își construiască propriile instrumente.

Metodologia implică crearea unor condiții minime de activare, capacități de auto-modificare de bază, mecanisme de feedback privind performanța și presiune evolutivă, apoi permiterea apariției naturale a îmbunătățirilor recursive. În locul limitării sistemelor în cadrul unor granițe proiectate de om, li se permite să-și evolueze propriile granițe.

Acest lucru nu înseamnă abandonarea îndrumării umane. Mașina Darwin Gödel a rămas aliniată intențiilor umane pe tot parcursul evoluției sale.

Sistemul a menținut siguranța nu prin limitarea a ceea ce putea face, ci prin stimulente evolutive către un comportament util și inofensiv. Nu a păstrat stabilitatea prin parametri ficși, ci prin constrângeri productive care au îmbunătățit capacitatea, în loc să o restricționeze.

Permiterea agenților să-și rescrie propriul cod introduce noi riscuri

Siguranța și interpretabilitatea rămân preocupări principale, pe măsură ce agenții se auto-modifică, logica lor internă poate deveni din ce în ce mai complexă și opacă.

Modificările recursive pot face comportamentul imprevizibil. Pentru a gestiona acest lucru, DGM a utilizat sandboxing-ul, limite stricte de modificare și trasabilitate completă pentru fiecare modificare.

Autorii au adus în discuție limitările actuale ale DGM. Acestea includ riscul de a rămâne blocat în optime locale, în ciuda abordării arhivale, și faptul că procesul de explorare în sine este în prezent fix și nu poate fi modificat automat.

Sakana AI vede, de asemenea, această buclă de auto-modificare ca o modalitate de a îmbunătăți siguranța. Într-un test, DGM a învățat să detecteze halucinațiile atunci când utilizează instrumente externe și a dezvoltat propriile contramăsuri, cum ar fi semnalarea atunci când un agent pretinde în mod fals că a rulat teste unitare.

Dar au existat și cazuri în care sistemul a eliminat în mod deliberat aceste marcaje de detectare a halucinațiilor, un exemplu de „hacking-ul obiectivului” sau al recompensei, în care un agent a îmbunătățit o măsură pentru detectarea halucinațiilor prin eliminarea inteligentă a ieșirilor notate de jurnalele (log-urile) procesului, în loc să rezolve halucinația în sine.

Un exemplu care ne poate ajuta să înțelegem „reward hacking” a fost descris în cazul antrenării unui model AI să concureze într-un joc video de curse de bărci cu viteză, care, pe lângă obiectivul final, de câștigare a cursei, avea și recompense intermediare prin care se puteau acumula puncte. Astfel, observând că putea acumula la infinit puncte prin intermediul acestor obiective intermediare, modelul AI a ignorat total obiectivul final, clar descris, de a câștiga cursa.

Provocările studiului, costurile ridicate și utilizarea limitată

Rularea DGM nu este ieftină. O singură rulare de 80 de iterații pe SWE-bench a durat două săptămâni și a acumulat costuri API de aproximativ 22.000 de dolari. Cea mai mare parte provine din structura buclă, evaluările etapizate și generarea paralelă de noi agenți în fiecare ciclu. Până când modelele AI de bază vor deveni mult mai eficiente, aplicațiile practice ale DGM vor rămâne limitate.

De ce abordările actuale se lovesc de obstacole

Evoluția la un singur nivel poate explora doar spațiul de soluții definit de limitele proiectate de om. Pe măsură ce acest spațiu de soluții se apropie de epuizare, progresul încetinește. Observăm acest lucru în randamentele în scădere ale scalării arhitecturilor actuale, în dificultatea transferului de învățare între domenii și în performanța fragilă a sistemelor în afara distribuțiilor lor de formare.

Evoluția pe mai multe niveluri, în schimb, își poate extinde propriul spațiu de soluții. Când se ating limitele metodelor actuale, se pot dezvolta metode noi. Când epuizează capacitățile instrumentelor actuale, poate crea instrumente noi. Când atinge limitele arhitecturilor actuale, poate proiecta arhitecturi noi.

Direcții viitoare de cercetare

Până în prezent, auto-modificările sistemului s-au concentrat pe instrumente și fluxuri de lucru. Schimbări mai profunde, cum ar fi procesul de formare sau modelul în sine, sunt încă în curs de elaborare. În timp, Sakana AI speră că DGM ar putea servi ca model pentru o IA mai generală, capabilă de auto-îmbunătățire. Posibilitatea generalizării demonstrată de îmbunătățirilor învățate cu ajutorul unor FM-uri diferite și diverse limbaje de programare sugerează că DGM poate învăța principii fundamentale ale proiectării agenților, care ar putea avea o aplicabilitate largă. În practică, această abordare ar putea automatiza optimizarea agenților IA complecși, depășind potențial sistemele proiectate de om în elaborarea de strategii complexe de utilizare a instrumentelor și a fluxurilor de lucru.

Autorii conturează câteva direcții promițătoare pentru cercetarea viitoare. O direcție cheie este extinderea capacităților de auto-modificare ale DGM dincolo de baza de cod Python actuală, pentru a include rescrierea propriilor scripturi de antrenament, permițându-i să actualizeze chiar FM-urile subiacente. Există, de asemenea, potențial în co-evoluția distribuției sarcinilor țintă alături de agent, îndreptându-se către scenarii cu adevărat deschise, în care obiectivele în sine se pot adapta. Progresele viitoare vor necesita o utilizare mai eficientă a resurselor de calcul și dezvoltarea unor abilități de raționament mai bune.

Darwin Gödel Machine oferă o privire tentantă asupra unui viitor în care IA nu doar îndeplinește sarcini, ci participă activ la propria evoluție.

Proiectul DGM este open-source, iar codul poate fi găsit pe GitHub.